La valutazione nella

scuola italiana è,

di fatto,

“pervasiva”. Lo è

soprattutto nei

tempi, giacché la

normativa vigente,

ripresa in ogni

delibera del

Collegio dei

Docenti, al fine di

rendere valido

l'anno scolastico,

impone un “congruo

numero di

valutazioni” (1).

Nella didassi,

questo si traduce in

molte ore spese per

soddisfare questo

criterio, attraverso

elaborati scritti

(poi corretti dai

docenti con ore e

ore di lavoro poco

riconosciuto) o

attraverso

interrogazioni orali

(che hanno il

“vantaggio” di non

dilatare i tempi di

lavoro del docente,

ma l'enorme

svantaggio di

comprimere quelli di

lavoro effettivo in

classe). Anche le

alternative

possibili

(valutazione di

lavori di gruppo,

elaborati

informatici e di

laboratorio in

genere) sono “time

consuming”. Una

possibile

trasformazione

ideale del momento

valutativo in

momento didattico,

quello che immagina

di trasformare le

interrogazioni in

momenti di ripasso

generale,

problematizzazione,

dialogo maieutico,

approfondimento, è

spesso

un'aspettativa

ampiamente disattesa

dalla prassi

concreta che vede

dinamiche di gruppo

involute e il

coinvolgimento del

solo interrogando.

Durante

un'interrogazione

partecipata, invero,

si re-instaurerebbe

la “lezione

dialettica” (2) di

stampo medioevale

dove si forniscono

quei feedback capaci

di evolvere

significativamente

le conoscenze degli

studenti, ma tali

opzioni sono colte

solo da gruppi

ristretti e motivati

di studenti (numero

fortemente

dipendente dal tipo

di scuola e dalla

classe sociale delle

famiglie degli

studenti). Le

tecnologie, come

spiegheremo nel

prosieguo, possono

dare un

significativo

contributo nella

costruzione di un

“congruo numero di

voti” senza che

questo sia “time

consuming” né per il

docente, né per il

lavoro in classe

(che può quindi

maggiormente

volgersi ai lavori

di gruppo e ai

laboratori).

È utile esplicitare

l'influenza

dell'arbitrarietà nella

scelta di una scala,

sull'attribuzione di

significato valutativo

sui livelli della

stessa. Esiste un ampio

spettro di scale

numeriche nella

tradizione scolastica e

universitaria italiana.

Oltre a quella classica,

da uno a dieci (3), è

possibile rilevare anche

scale in sessantesimi e

centesimi (esame di

Stato della SSSG fino

all'a.s. 1997/8 e,

rispettivamente, dopo

tale data), scale in

30mi e 110mi (esami

universitari e

valutazione finale di

laurea e di altri

percorsi, come ad

esempio Master), ma

anche scale in 80mi

(SSIS per abilitazioni

su materia e

specializzazione su

sostegno), 30mi (TFA,

altri Master).

Le opzioni si allargano,

se si guarda all'estero,

dove ad esempio le

valutazioni scolastiche

e gli esami universitari

in area francofona hanno

una scala in 20mi (il

livello di sufficienza è

fissato a 10). Orbene,

affidandoci al nostro

“senso comune” possiamo

dire che, a scuola, 7 è

un bel voto. Ma qual è

un bel voto

all'Università? Ebbene,

al netto delle

differenze tra questo e

quell'indirizzo di

studi, penso che

potremmo ragionevolmente

convenire sul fatto che

a partire da 27 si

trovino i “buoni voti”.

Un ragionamento

proporzionale porta

tuttavia ad osservare

che per nessuno studente

universitario un 7 su

10, tradotto in

trentesimi, quindi 21,

sia un buon voto.

Gli studenti Erasums

sanno perfettamente che

è vantaggioso passare da

un'Università che dà

voti in scale piccole

(ad esempio dalla

Francia o dal Belgio

dove i voti sono in

ventesimi) ad una dove i

voti sono dati su scale

ampie (ad esempio in

Italia dove i voti sono

in trentesimi) perché

proporzionalmente un

24/30, che è un voto

mediocre, si traduce in

16/20, che è già un

ottimo voto.

Questo effetto di

“attrazione verso

l'alto” mette in

evidenza la povertà

delle argomentazioni

favorevoli al voto

numerico come elemento

di chiarezza giacché i

numeri, senza una

conoscenza della cultura

e della corrispondente

tradizione semantica ad

essa accordata, non sono

per nulla oggettivi e

chiarificatori.

|

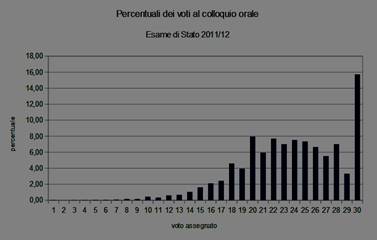

Nella figura qui a fianco e in quella successiva vengono raffigurati gli istogrammi delle percentuali delle valutazioni orali all'esame di Stato del 2011/12 e del 2014/15 (4). Si noterà in particolare la significativa discontinuità nella valutazione del 30, con un po' più di attenzione, si noterà anche quella del 20 (ma anche quelle poste a “-2” da tali soglie, cioè quelle del 18 e del 28). La particolarità della prima coppia di voti (20 e 30) è che il primo è il massimo possibile, mentre il secondo rappresenta il livello di sufficienza, cioè rappresenta una soglia. La seconda coppia di voti rappresentano comunque una soglia psicologica degli insegnanti che, avendo nel primo caso un'esperienza vissuta sul tema degli esami universitari e la loro scala valutativa, hanno introiettato il 18 come valore di sufficienza; per entrambi i voti della seconda coppia si tratta anche di “soglia tecniche/psicologiche” che esplicitano un colloquio insufficiente, o molto buono (ma non ottimo) per il quale la commissione fornisce un risultato numerico che non vuole essere troppo penalizzante e, comunque, autocautelativo. Da un punto di vista astratto, la griglia di valutazione utilizzata dalle commissioni dovrebbe fornire, almeno sulla popolazione nazionale, curve più morbide/continue, ma l'interferenza di elementi cogenti della realtà dell'esame sulle griglie, appare evidente. |

|

È opinione diffusa,

invero, che le griglie

di valutazione vengano

compilate ex post, cosa

che denuncia una certa

impreparazione culturale

sulla tematica, la cui

formazione, ad onor del

vero, non è mai stata

erogata, se non ai

presidenti di

commissione (il cui

unico requisito che

devono soddisfare per la

nomina è l'esperienza di

“dieci anni di ruolo”),

chiamati ad una

“riunione tecnica”

provinciale da ogni

Ufficio Scolastico

Provinciale (USP).

Occorre anche notare che

le griglie elaborate

dalle commissioni non

sono nazionali e

pertanto l'attenzione

del docente non è

adeguata anche per il

fatto che, almeno

psicologicamente, è

comunque lui il

“valutatore” e uno

strumento autocostruito

appare come una

complicazione inutile

che viene soddisfatta

solo per fini ritenuti

di ordine burocratico.

Occorre evidenziare il

fatto che, in maniera

del tutto naturale, i

voti di una classe sono

significativi “per

quella classe” e

forniscono una scala non

confrontabile con altre

classi, come le

rilevazioni INVALSI

hanno mostrato con

solidità statistica. Nè

sarebbe utile, nel

lavoro in classe, che

fosse il contrario. La

sensazione è che la

stessa cosa valga anche

per i voti degli esami

di Stato della SSSG che,

pur avendo prove comuni

(due scritti),

forniscono voti

mediamente alti in

alcune regioni e più

bassi in altri (ogni

anno, ha sempre

rilevanza giornalistica

il numero dei 100/100 e

dei 100 e lode in

provincia di Milano e in

Calabria, rilevanza che,

almeno recentemente, ha

raggiunto anche vette di

becerume retorico

culturalmente

inaccettabile) (5).

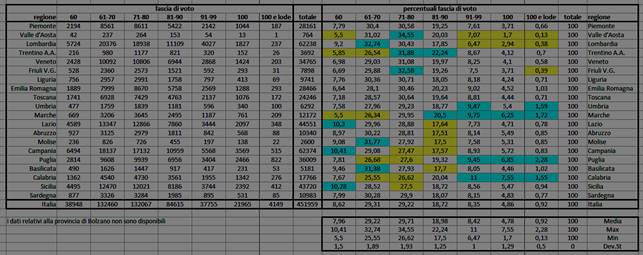

Nella figura più sotto

sono indicati i voti

conseguiti nell'a.s.

2014/15 dagli studenti

in uscita dalla SSSG,

suddivisi per regioni.

Nella prima parte della

tabella si trovano i

valori assoluti, nella

seconda quelli

percentuali. In questa

seconda parte ho

proposto un'elaborazione

che evidenzia i valori

significativamente sotto

o sopra la media (di una

deviazione standard). Si

osserverà come gran

parte dei valori, quelli

a sfondo bianco, sono

entro valori accettabili

di scostamento dalla

media, mentre quelli a

sfondo colorato

segnalano differenze

che, dal nord a sud,

passano dal sopramedia a

sinistra per i voti

bassi e sottomedia a

destra per i voti alti

in settentrione, per

giungere ad

un'inversione scendendo

verso il sud. Appaiono

significativi i valori

sopramedia del voto

minimo in Sicilia, Lazio

e Campania (dove,

statisticamente, non si

nega il diploma a

nessuno, sancendo un

valore empirico di

diffidenza per il voto

minimo, sessanta

centesimi, largamente

percepito in tutto il

paese). Si confermano le

tesi giornalistiche

relative allo scarso

numero di voti massimi

al nord, le regioni più

penalizzate sono la

Valle d'Aosta, Lombardia

e Friuli Venezia Giulia,

mentre sono

significtivamente sopra

la media non solo un

paio di regioni del sud

(Puglia e Calabria), ma

anche del centro (Umbria

e Marche) (6).

Paolo Francini, insegnante attivo a livello nazionale, sul tema della valutazione in uscita dalla SSSG, in occasione di un recente dibattito sul tema “Le due Italie della Maturità” sviluppato entro la lista di discussione “Cabrinews”, su questo tema propone le seguenti riflessioni: «La cosa curiosa è che la valutazione analitica, materia per materia, era precisamente quanto succedeva fino al 1968, quando non c'era un valore di sintesi situato su una scala unidimensionale (in 60-esimi o 100-esimi), ma appunto voti d'uscita nelle varie discipline. Si poteva superare l'esame con 9 in latino e 6 in matematica, e la cosa era trasparente. Si poteva tranquillamente essere rimandati a settembre in una o più materie all'esame. Tra l'altro, ciò non è molto differente da quello che tuttora avviene nelle scuole di molti paesi (in particolare quelli anglosassoni).

Forse era già quella, a suo modo, una certificazione delle competenze (da cui poi ci siamo allontanati per immergerci in una sorta di guazzabuglio assai più opaco)? Faccio presente che, tra l'altro, la scuola tracciata dalla riforma Gentile in realtà non prevedeva programmi di insegnamento, bensì programmi d'esame per ciascuna materia, predisponendo numerosi esami nella carriera studentesca: 2a elementare, 5a elementare, ginnasio inferiore (che diventa scuola media), ginnasio superiore, maturità.

Si fissavano, cioè, dei traguardi nel percorso in termini di preparazione da acquisire e si stabiliva come dovevano avvenire le verifiche in sede d'esame, ma si lasciava libertà didattica e metodologica all'insegnante (ciò che avrebbe in parte voluto essere realizzato con l'autonomia scolastica, ma non è stato). Questo impianto fu poi quasi subito smantellato ed annacquato (troppe proteste) e si passò presto a dei programmi d'insegnamento. In ogni caso, la pretesa di usare correttamente una scala unidimensionale centesimale, così come impostata dall'attuale ordinamento, è a mio modo di vedere irrealistica, data l'assenza di criteri di valutazione stringenti, trasferibili e terzi, nonché la difficoltà a controllare e uniformare le condizioni di svolgimento delle prove, nonché le personali aspettative dei diversi insegnanti. Tale pretesa non può che condurre ad esiti altamente fuorvianti. Qualcosa di simile succede, ad esempio, anche per i voti d'uscita delle università (scala addirittura in 110imi), salvo che nessuno ha mai indagato seriamente le distorsioni ivi sottese (che devono essere ancora più serie di quelle osservabili nella scuola).

Esiti un po' più attendibili potrebbero aversi utilizzando, per il livello d'uscita, una scala meno fine, con un numero più ridotto di gradini (ad esempio, come per le nostre scuole medie, o come in Francia dove il fondo scala è di 20 punti, che quasi nessuno raggiunge, e la sufficienza è 10, dunque 11 gradini e non 42).

Naturalmente, potrebbero

essere prese in

considerazione diverse

misure per incrementare

l'affidabilità delle

valutazioni finali. Ad

esempio: indicazione di

punteggi nelle singole

parti delle prove

d'esame; guida alla

correzione e

pubblicazione di

indicazioni stringenti

per la valutazione da

parte del ministero

(come accade in molti

paesi e come succede per

le prove Invalsi);

correzione anonima dei

compiti scritti su base

provinciale,

eventualmente anche con

sistemi tipo "doppia

giuria" (se i due voti

assegnati differiscono

troppo, si ricorre ad un

terzo giudizio);

commissioni senza

componenti interni e con

membri di altre regioni;

voti orali assegnati

senza conoscere l'esito

degli scritti; revisione

radicale della terza

prova (o sua

eliminazione). Una

misura minima potrebbe

essere quella di

sottoporre a vigilanza

più attenta (presenza di

ispettori in loco),

negli anni seguenti, le

scuole dove i risultati

appaiono più anomali.

Già questo sarebbe un

accettabile dissuasore.

Invece, evidentemente,

la cosa è stata lasciata

a se stessa e non

interessa realmente a

nessuno, al di là delle

polemiche agostane di

ogni anno. Tanto più che

alcune macroscopiche

anomalie di questi dati

hanno cominciato a

risaltare da almeno un

decennio in maniera

sempre più nitida, ma

non si è mai

intervenuti».

Occorre esplicitare a questo punto una contraddizione insanabile nello sforzo di valutare gli studenti con un numero (nella scuola italiana, dall'1 al 10). Quando si usa la parola “valutazione” spesso la si confonde con “misurazione”. Orbene, in questo secondo ambito, è possibile misurare laddove si trovi un campione di riferimento e si possono misurare e mettere in relazione di minoranza/maggioranza solo valori scalari. Stabilito un verso nella “retta dei numeri”, possiamo sempre stabilire chi sia prima e chi sia dopo, ovunque si fissi l'origine.

Tutti, quindi, possiamo “mettere in ordine” dei numeri, ma questo non è più possibile, data l'arbitrarietà del sistema di riferimento, appena un carattere fosse descritto da un vettore (cioè da qualcosa che abbia più di una dimensione). In matematica è ben noto il fatto che i vettori non siano ordinabili. Possiamo rappresentare graficamente un vettore bidimensionale su un piano cartesiano, con un punto, mentre la rappresentazione algebrica è la definizione di una coppia di valori. Quando, una coppia, è più grande dell'altra? Il tentativo ingenuo di considerare la distanza dall'origine degli assi si scontra con la loro posizione arbitraria.

Quando valutiamo uno studente, quindi, ci troviamo nella seguente situazione: dobbiamo costringere in un numero, elementi che sono, per propria natura, afferenti a “categorie” diverse, quindi la valutazione dovrebbe essere “vettoriale”. A titolo di esempio: conoscenze, competenze, capacità, atteggiamenti, esposizione, etc. Ma quante sono le dimensioni di una persona? La situazione che si genera è sostanzialmente nota nell'ambito delle reti neurali, allorquando si cerchi di mappare uno spazio universo non del tutto conosciuto a priori, attraverso un numero di indicatori emergenti da quanto noto. Facciamo l'esempio di mappare i punti di un quadrato (lo spazio universo ignoto), disponendo di un filo. È chiaro che, sapendo che si tratta di un quadrato, il modo migliore di definire le coordinate di un punto (in un linguaggio più pratico, prestato dalla geografia e dall'informatica potremmo dire “l'indirizzo del punto”) è quello di misurarne le coordinate (ascissa e ordinata con le coordinate cartesiane, distanza dall'origine e inclinazione con quelle polari). Disponendo di un filo, potremmo procedere a zig zag dal basso verso l'alto o dal centro con percorso a spirale. In entrambi i casi, possiamo dire che due punti molto vicini nel filo sono vicini anche nello spazio quadrato, mentre punti molto distanti nella “mono-coordinata”, possono invero essere anche molto vicini nello spazio del quadrato. Questo “effetto matematico” è ineludibile e suggerisce un'inevitabile conseguenza: la valutazione numerica è povera e, spesso, anche poco significativa giacché due studenti con voto di 7 e 8 (voti vicini), possono essere non tanto dissimili da uno con voto 3 (voto distante, nello spazio lineare, ma cosa si può dire dello “spazio delle competenze”, visto che è multidimensionale e la scelta delle componenti, una sua probabile riduzione di complessità?).

Una prima alternativa semplice e praticabile consiste nella via anglosassone che riduce i voti a cinque singole lettere: A, B, C, D, E (Fasce, 2014a) che non cancellano la riduzione ad una sola dimensione, ma che hanno il vantaggio di godere di un'alta probabilità di accordo nei seguenti termini. Roberto Franchini, in occasione di un corso di formazione per insegnanti organizzato dall'UCIIM sul tema della valutazione, distribuì un tema ad un largo gruppo di maestre, chiedendo di dare un voto (da 1 a 10). Raccolse quindi i valori in un istogramma, ottenendo una distribuzione a “campana di Gauss”. Quindi, qual è il “voto” di questo tema? È opinabile, anche se quest'esperimento consentirebbe di darne una “stima ragionevole”. Invertendo la prospettiva, ammesso che il voto possa essere correttamente stimato dalla media di una sufficiente numero di valutatori, un voto espresso da un solo valutatore ha più alta probabilità di essere quello corretto dove il numero di livelli è basso. Qualsiasi manuale di valutazione propone cinque livelli che sostanziano le parole chiave: ottimo, buono, sufficiente, insufficiente, disastroso.

Una prima soluzione, incarnata dal riformismo scolastico degli anni Settanta/Ottanta del secolo scorso, è la stesura di giudizi descrittivi, mai instaurati nelle scuole secondarie di secondo grado (già “medie superiori”) e aboliti nel primo ciclo d'istruzione (scuola primaria e scuola secondaria di primo grado, già elementari e “medie inferiori”) dalla “Riforma Gelmini”. L'esperienza di decenni di giudizi discorsivi/descrittivi non ha tuttavia fatto emergere molte buone prassi, schiacciando i giudizi in parole chiave dal significato scientifico del tutto simile a quello dei voti numerici. Una possibile soluzione di questo problema consiste nell'esplicitare rubriche di valutazione ricche di indicatori significativi, che peraltro sarebbero contemporaneamente sommativi (nel senso che misurano determinati parametri), che orientativi e formativi (perché metterebbero in luce i punti di forza e di debolezza). È probabilmente impossibile, per ragioni anche legate alle connessioni neuronali, individuare “indicatori monodimensionali”, per la natura frattale del problema, ma già in questo contesto non si avrebbero quegli squallidi confronti ai quali abituiamo i bambini, oggi fin da piccoli, concentrando l'attenzione sul voto e su chi ha preso di più o di meno. In una “rubrica di valutazione” si possono confrontare le varie voci, ma è improbabile che un bambino sia superiore in tutte e, comunque, fare un confronto è molto meno immediato.

Una descrizione

multidimensionale,

che cattura la

ricchezza

dell'articolazione

delle competenze

(conoscenze,

abilità, attitudini,

ciascuna

ulteriormente

articolata in

indicatori) darà

sempre e comunque

un'idea più adeguata

della situazione

osservata. È,

infine, difficile

costruire questo

genere di rubriche e

una soluzione al

problema, che si

basa su

collaborazioni

ampie, è avanzata

nell'ultimo capitolo

della presente tesi.

----------------------------------------------------------

1 La locuzione

affonda le sue

origini nel Regio

Decreto 653 del 4

Maggio 1925 che

all'art. 79 recita:

«... I voti si

assegnano, su

proposta dei singoli

professori, in base

ad un giudizio

brevemente motivato

desunto da un

congruo numero di

interrogazioni e di

esercizi scritti,

grafici o pratici

fatti in casa o a

scuola, corretti e

classificati durante

il trimestre o

durante l'ultimo

periodo delle

lezioni». Si

attualizza, ad

esempio, nella

Circolare

Ministeriale 89/2012

si legge: «Resta

comunque inteso,

come principio

ineludibile, che il

voto deve essere

espressione di

sintesi valutativa e

pertanto deve

fondarsi su una

pluralità di prove

di verifica

riconducibili a

diverse tipologie,

coerenti con le

strategie

metodologico-didattiche

adottate dai

docenti. Sarà cura

quindi del collegio

dei docenti e dei

dipartimenti fissare

preventivamente le

tipologie di

verifica nel

rispetto dei

principi definiti

dai decreti

istitutivi dei nuovi

ordinamenti». Detta

locuzione, tuttavia,

non appare nella

normativa recente ed

è più probabile una

sua origine

giuridica, viene

infatti rilevata, ad

esempio nella

Sentenza 213 del

23/1/2009 del TAR

della Lombardia.

2 Calvani, A. "La lezione in classe funziona o non funziona?", Schede evidence-based di S.Ap.I.E.: «La lezione non ha sempre avuto il formato trasmissivo e monodirezionale che ha assunto in tempi moderni. La lectio medievale prevedeva la discussione tra le opinioni del maestro e quelle contrarie all’interno di un fitto dibattito; poi la lezione si è svuotata della sua componente dialettica, è sopravvissuta come semplice trasmissione di informazioni, ad arbitrio del docente». http://www.sapie.it/images/SchedeSApIE/SApIEschedelalezione.pdf

(ultima

consultazione,

30/7/2016)

3 Una critica

pungente alle

valutazioni decimali

e all'ipercampionamento

che viene di solito

generato nei voti

che vanno da cinque

a sette, segnalo un

articolo “Dal 5 al

6, 6 meno meno etc...

ma con quali criteri

la scuola dà i voti”

pubblicato sul blog

scolastico “Pensieri

sottobanco” incluso

sul sito de Il

Secolo XIX

(http://www.ilsecoloxix.it/p/blog/2016/05/28/AS83YhtC-quali_criteri_scuola.shtml).

4 Dati

ottenuti

dall'Ufficio VI

“Statistiche e

studi” del MIUR. Le

rilevazioni del

2015/16 non erano

ancora disponibili

durante

l'elaborazione di

questa tesi.

5 Uscendo da sterili polemiche giornalistiche, Anna Maria Ajello, presidente INVALSI, è intervenuta sul tema con un contributo pregevole, pur sintetico e divulgativo, su “Il Sole 24 ore” il 26/8/2016 dal titolo “Maturità, dal divario Nord-Sud nei voti con lode un'opportunità per interrogarsi sul sistema scolastico”

6 I dati dell'ultimo

anno scolastico sono

stati rilasciati in

un comunicato stampa

che si segnala, ma

sul quale non sono

state fatte

elaborazioni in

questo contesto in

quanto i dati

sottesi non sono

stati resi

disponibili (http://hubmiur.pubblica.istruzione.it/web/ministero/cs100816).